Rozumějí našemu jazyku, mluví s námi a třeba i píšou básně. Úspěchy velkých jazykových modelů, jako je GPT-4 nebo Gemini, jsou impozantní. Otevírají nové možnosti v tak rozmanitých oblastech života, jako jsou komunikace, učení a kreativita.

Přes všechny zázraky má však tato nová technologie i jednu málo zmiňovanou stinnou stránku: jazykové schopnosti modelů jsou založeny na umělých neuronových sítích s miliardami parametrů a jejich trénink a provoz spotřebovává obrovské množství elektrické energie. Počet uživatelů chatbotů přitom rychle roste, což způsobuje, že nezadržitelně roste i spotřeba energie.

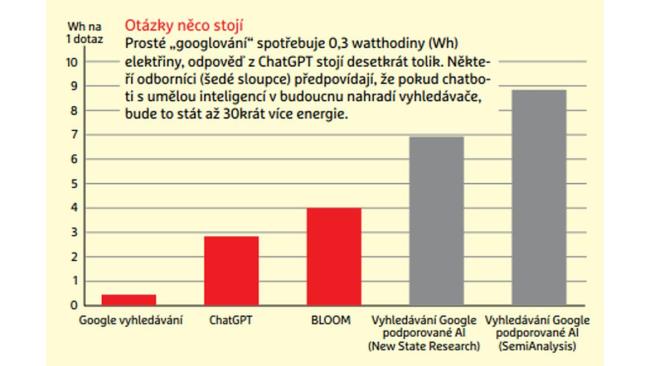

Podle pesimistických odhadů může dotaz na chatbota stát až 30krát více energie než prosté vyhledávání na internetu pomocí klíčových slov. Extrapolováno na současných devět miliard dotazů na Google by to znamenalo potřebu elektřiny v řádu spotřeby malé země, jako je třeba Irsko. A dokonce i počáteční trénink velkého jazykového modelu si obvykle vyžádá náklady na elektřinu ve výši jednotek až desítek milionů korun).

Spotřeba energie neznámá

Abychom mohli tuto spotřebu účinně snížit, je třeba ji nejprve podrobně znát. „Podle našich zkušeností však tvůrci těchto modelů sami často nevědí, k čemu přesně energii využívají,“ říká Peter Radgen, profesor Institutu energetického hospodářství a racionálního využívání energie na Univerzitě v německém Stuttgartu. V projektu NADIKI (česky Ukazatele udržitelnosti pro digitální infrastrukturu a AI) si jeho tým stanovil za cíl zpřístupnit a zprůhlednit spotřebu energie a související emise CO2 realizované aplikacemi umělé inteligence.

Profesor Radgen vidí možné východisko v udržitelnějším využívání kapacit datových center umělé inteligence. „Efektivita je vždy nejvyšší, když počítače pracují na optimální kapacitu,“ vysvětluje výzkumník. Servery jsou však často nečinné a spotřebovávají energii, aniž by pracovaly produktivně. „Je to jako nechat v autě neustále běžet motor jen proto, abyste mohli kdykoli okamžitě odjet.“ Podrobná analýza open source jazykového modelu BLOOM odhalila, že třetina energie spotřebované na trénování byla vyplýtvána právě na nečinné počítače.

„Proto je naším cílem v rámci projektu NADIKI umožnit měření spotřeby energie až na úrovni jednotlivých počítačů,“ říká Radgen. „Jedině tak mohou vývojáři aplikací umělé inteligence získat představu o spotřebě energie, kterou způsobují.“ To je důležité i proto, že řešení jedné a téže úlohy může spotřebovávat různé množství energie – podle toho, kolik dalších znalostí je programátor ochoten do své umělé inteligence nacpat. „Jak je k dispozici stále výkonnější hardware, vývojáři často volí jednodušší cestu a nechají hledat řešení AI, místo aby přemýšleli sami,“ říká Radgen. Modely berou v úvahu stále více parametrů, a proto vyžadují hodně energie.

Aby ukázal, jak může lidská inteligence snížit energetické nároky umělé inteligence, odkazuje Radgen na prognózy výroby elektřiny z fotovoltaických systémů při trénování AI. „Nejjednodušší způsob je tvrdošíjně trénovat umělou inteligenci po celých 24 hodin,“ říká výzkumník. Jako člověk však víte, že systém v noci nic nevyrobí, a můžete tuto informaci využít k dočasnému snížení objemu zpracovávaných dat. „V konečném důsledku to nemá žádný vliv na kvalitu výsledků,“ říká Radgen. „Pravděpodobně budou dokonce lepší.“

V současné době se však zdá, že zejména velikost jazykových modelů se z generace na generaci zvětšuje. Zatímco GPT-3, na němž je založen i ChatGPT, měl „pouze“ 175 miliard parametrů, u jeho nástupce GPT-4 se prý toto číslo zvýšilo desetkrát. „V žádném případě však není nikde psáno, že modely musí být stále větší a větší,“ říká Stefan Naumann, profesor informatiky udržitelného rozvoje v environmentálním kampusu Birkenfeld na Univerzitě aplikovaných věd v Trevíru, který chce zpřehlednit spotřebu energie jazykových modelů. „Trend se také ubírá směrem k tomu, aby se co nejvíce věcí dělalo přímo na chytrých telefonech nebo jiných koncových zařízeních.“

AI ve smartphonu

Google například nedávno představil Gemini Nano, zmenšenou verzi svého vlajkového jazykového modelu Gemini, kterou lze spustit i offline na mobilních telefonech. „Pokud modely běží decentralizovaně na koncových zařízeních uživatelů, snižuje se tím nejen spotřeba energie, ale také se lépe chrání soukromí,“ říká Naumann.

Bylo by však nutné přijmout určité kompromisy z hlediska výkonu a chatbot by se možná musel spokojit s tím, že bude mít přístup pouze k určitému množství základních znalostí, a ne například k celé Wikipedii. V konečném důsledku by tak mohly vzniknout hybridní modely, které budou schopny zpracovávat jednoduché dotazy lokálně, ale pro obšírnější dotazy budou využívat rozsáhlou knihovnu.

„Uvidíme, kolik toho smartphone skutečně dokáže,“ říká Naumann a srovnává to s editací obrázků, kde ještě před několika lety nebylo téměř možné aplikovat filtry a dělat úpravy přímo na smartphonu. „Dnes už se tyto úpravy provádějí lokálně na koncovém zařízení, protože výpočetní výkon se zvýšil a nyní to umožňuje.“

Počítač v každé větrné turbíně

Kromě optimalizace softwaru a hardwaru může k větší udržitelnosti vést také využívání ekologických zdrojů. Centrum výkonných počítačů ve Stuttgartu (HLRS) v rámci projektu WindHPC připojuje k datovému centru poprvé počítače umístěné přímo na větrné farmě. Při silném větru tyto turbíny často vyrábějí více elektřiny, než smějí dodat do sítě. Aby se takové výkyvy vyrovnaly, mohou se pak části výpočetní úlohy přesunout z hlavního počítače ve Stuttgartu na větrnou farmu. Tento postup je vhodný vždy, když čas není při výpočtech tak kritickým faktorem.

> Ve věžích je určitě dost místa. Vnitřní prostory mají zpravidla plochu o rozloze kolem 10 m2 a jsou obvykle zcela prázdné. Takový externí počítač však samozřejmě nemůže mít stejné rozměry jako jeho velký bratr v HLRS, který má k dispozici prostor sportovní haly. Počítač umístěný ve věži větrné turbíny vyžaduje napájení v řádu pouhých stovek kilowattů, což je zlomek z až šesti megawattů, které generuje velká větrná turbína. Elektrárna tedy nejenže provozuje počítač, když je to potřeba, ale také nadále dodává elektřinu domácnostem v okolí, které mají samozřejmě vždy přednost.

Datová centra se zahřívají

Energeticky náročné trénování modelů bude muset i v případě menších variant probíhat v datových centrech. Zpravidla představuje mnohem větší část spotřeby energie ve srovnání s aplikacemi, a proto se na něj projekt KIRA, v němž se Naumann a jeho tým rovněž podrobně zabývají ekologickou stopou umělé inteligence, soustředí. Protože mají k dispozici pouze omezené hardwarové zdroje, mohou sami skutečně trénovat pouze menší modely a měřit jejich spotřebu energie v průběhu tohoto procesu.

Trénování velkých modelů probíhá v obrovských datových centrech, kde v extrémních případech tisíce vzájemně propojených procesorů běží několik týdnů a, jako v případě GPT-3, produkují více než tisíc megawatthodin odpadního tepla. „To dokážou jen velké technologické společnosti, a proto se v současnosti musíme spoléhat jen na jejich údaje,“ říká Naumann. „Většina z nich však data o spotřebě elektřiny spíše skrývá.“

Často poskytují pouze informace o počtu výpočetních jednotek, grafických karet nebo procesorů použitých k tréninku umělé inteligence. Spotřebu energie, pokud ji vývojáři vůbec znají, zveřejňují jen zřídka. Proto se vědci jako Naumann a jeho kolegové musí spoléhat na extrapolaci toho, kolik energie se spotřebovalo, například z typu použitých procesorů a doby trvání tréninku.

Vědci mohou ke zpřesnění svých odhadů využít alespoň veřejně dostupná data z výše zmíněného open source jazykového modelu BLOOM. Je podobně velký jako GPT-3 a podrobné měření spotřeby energie během tréninku může sloužit jako model pro budoucí zprůhlednění umělé inteligence. „V každém případě musí být cílem, aby každá služba AI měla nakonec přiřazen jakýsi energetický štítek, který pak uživatelé mohou využít i k tomu, aby si hlídali svou ekologickou stopu,“ říká Naumann.