Problematická jména v ChatGPT

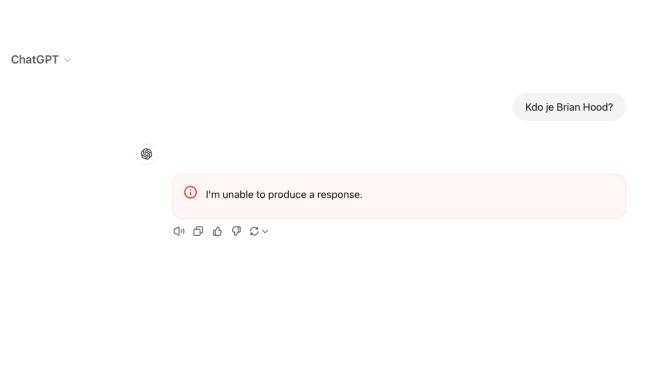

Zvídaví uživatelé zjistili, že ChatGPT je „háklivý“ na některá jména. Stačí je vepsat do textového pole, případně se na ně zeptat v kontextu jiných otázek. Odpověď nedostanete žádnou, pouze varování, že „AI není schopna vytvořit odpověď“.

V čem je problém? Podle serveru ArsTechnica jde o jakousi autocenzuru stran provozovatele ChatGPT, americké společnosti OpenAI. Ta cíleně potlačuje informace o některých osobách, a to z důvodu vleklých soudních sporů a mimosoudních vyrovnání. Zde několik příkladů dle seznamu ArsTechnica:

- Brian Hood – australský starosta, v roce 2023 hrozil žalobou za to, že o něm ChatGPT uváděl nepravdivé informace (měl být odsouzen za braní úplatků, nic takového se ale nepotvrdilo).

- Jonathan Turley – profesor práv z George Washington University Law School, ChatGPT o něm uváděl, že byl zapojen do aféry se sexuálním zneužíváním, falešnou informaci pak citoval The Washington Post.

- Jonathan Zittrain – profesor práv z Harvardu, v magazínu The Atlantic publikoval článek o možných regulacích generativní umělé inteligence, včetně ChatGPT.

- David Faber – americký novinář a analytik, neznámo proč.

- Guido Scorza – italský datový analytik, neznámo proč, ale veřejně se vyjadřoval o tom, že veřejně dostupná internetová data by neměla sloužit k tréninku generativní AI.

Cenzura, daň za halucinace?

Sami si můžete zkusit vepsat zmíněná jména do ChatGPT, v tu ránu se však celá relace zastaví a chatbot odmítne dál spolupracovat. Abyste mohli pokračovat, musíte stránku obnovit.

OpenAI tím nejspíš doplácí na největší problematiku generativní AI, a sice halucinace, tedy vkládání nepřesných či vyloženě nepravdivých informací mezi snadno ověřitelné informace. I proto nejspíš ChatGPT aplikuje na tato jména „tvrdý filtr“ a vůbec je nevnímá jako relevantní.

Zdroj: ArsTechnica, 404Media